空のむこうに続く道

状态

文章总数

77篇 总字数

12.4万 运营时长

2年11个月分类

标签

AI Arch BF CLI CSS C语言 Fuwari Giscus GTK HEO Hyprland jQuery JS KDE K签 Linux Lisp LLM Path Pypi Python RSS Textual TUI Vim VTB VUP Whl WP ジサツ 上海 下载 专业 主题 云朵 享乐 代码 优化 伦理 便利店 俄国 光标 内省 内耗 函数式 分析 创伤 创意 判断 前端 北京 参观 友谊 反思 可爱 和风 哲学 商业 回忆 国庆 壁纸 天津 女仆 姐妹 字典 学习 安装 实用 对话 工具 幻想 库 度假 开发环境 开源 归档 微风 心理 志怪 总结 意义 成都 技校 抚远 拥抱 推荐 插件 摄影 政策 故事 故障排查 效果 散文 文件 文化 旅游 日本 日语 时间 显卡 样式 模糊 汉化 治愈 浏览器 浦东 浦西 游戏 滑动 演讲 热力图 特效 猫猫 玩具 环境 甘城 生态 病毒 登录 盘点 直播 破译 社会 社团 视奸 秋游 科幻 移民 窗口 笔记 系统 红枫 终点 终端 经济 编译 美化 美缝 耳机 脑操 自动驾驶 苏州 茅山 萌系 补档 解释器 设计 评论 话术 语言 谷子 走路 轮子 辍学 迁移 运维 重庆 重构 链 随机 静安 音频 项目 颜文字 颜色 首都 魔法 麦金塔 鼠标

128 字

1 分钟

如何本地部署大模型

安装 Ollama

打开终端,通过 winget 安装 Ollama 引擎:

winget install ollama下载模型

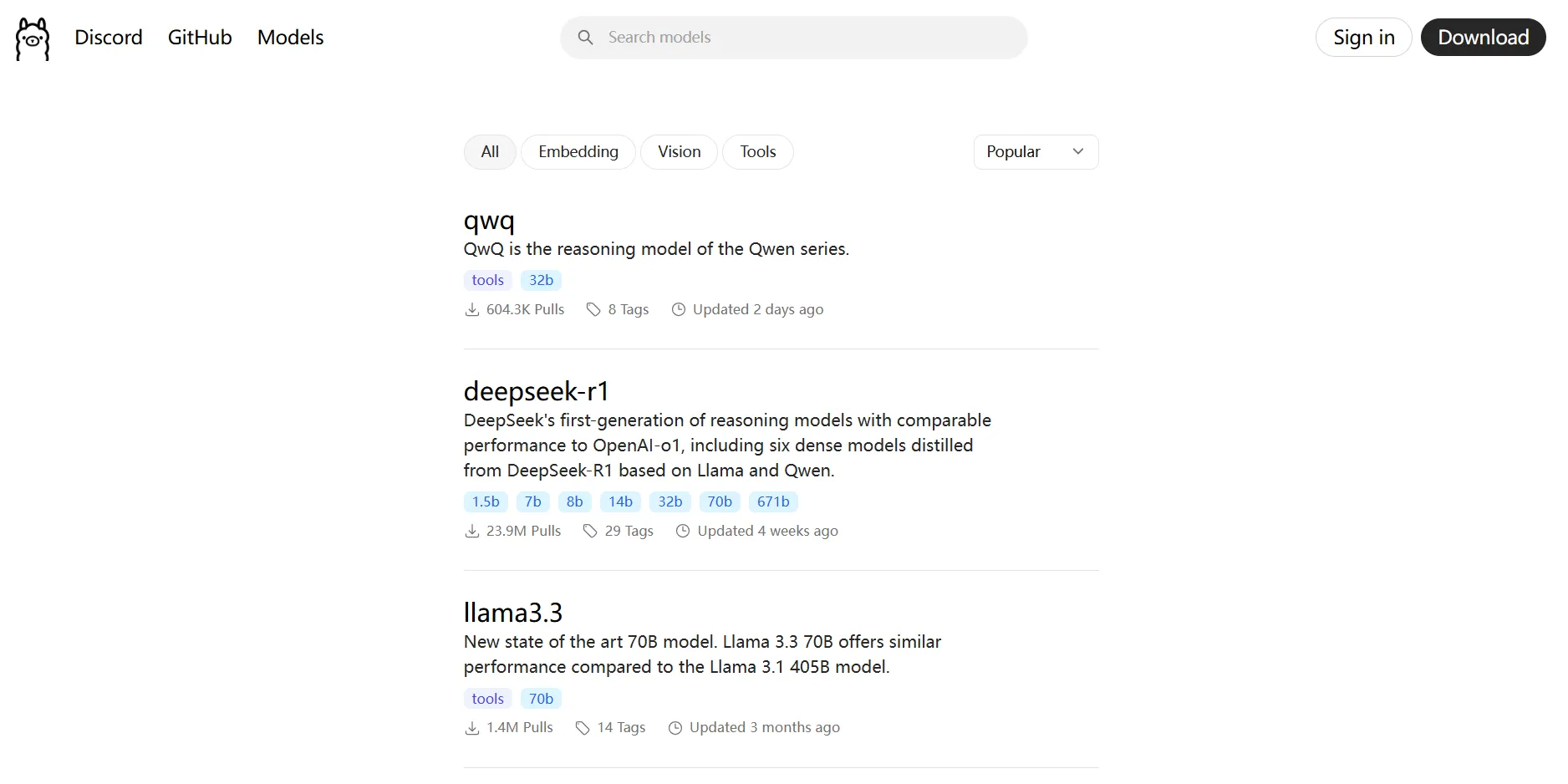

打开 Ollama 网站,选择一个你想要的模型:

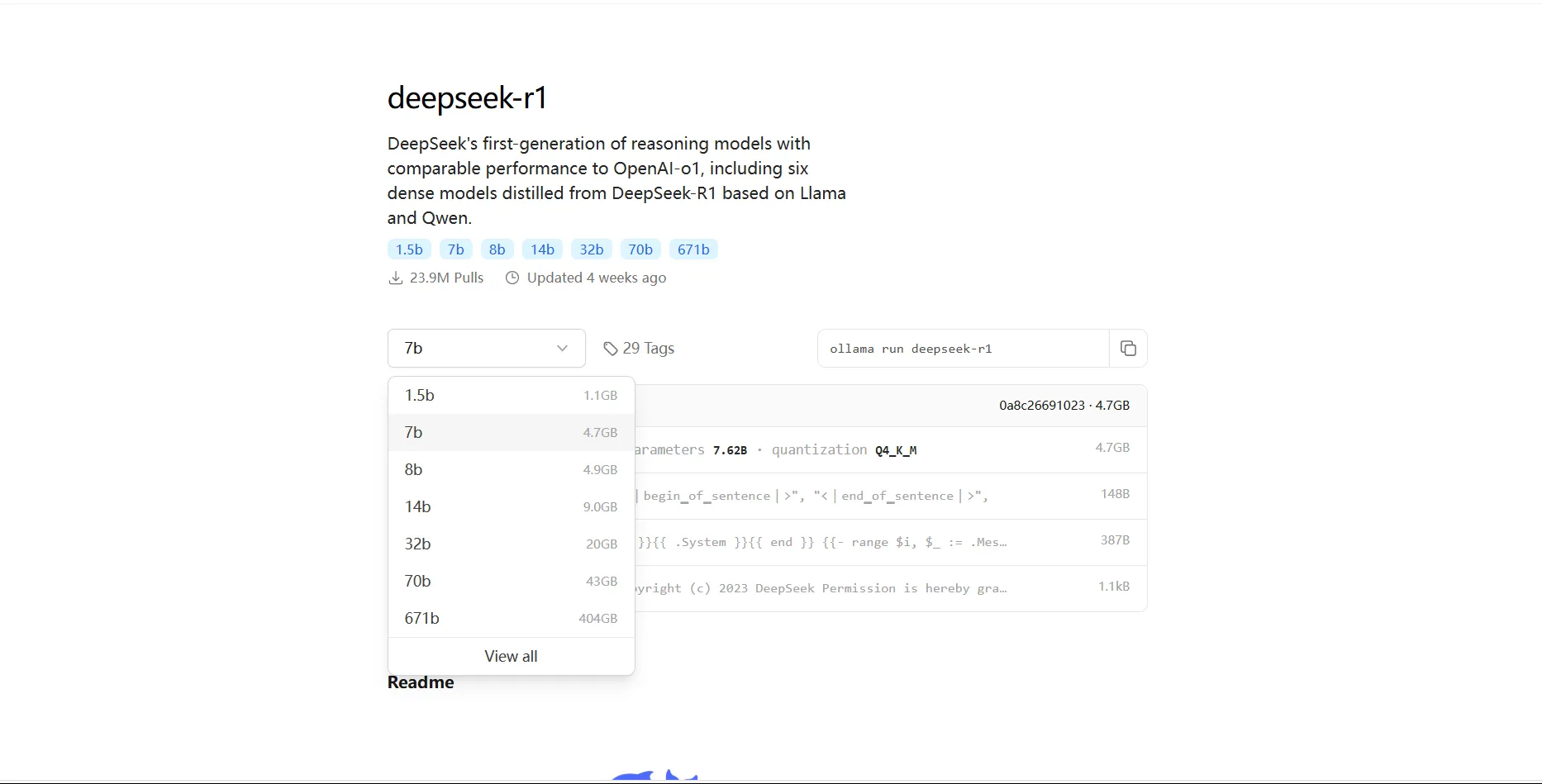

然后选择模型的参数量,参数量越大越聪明,但所需配置也需要更高:

安装和运行模型

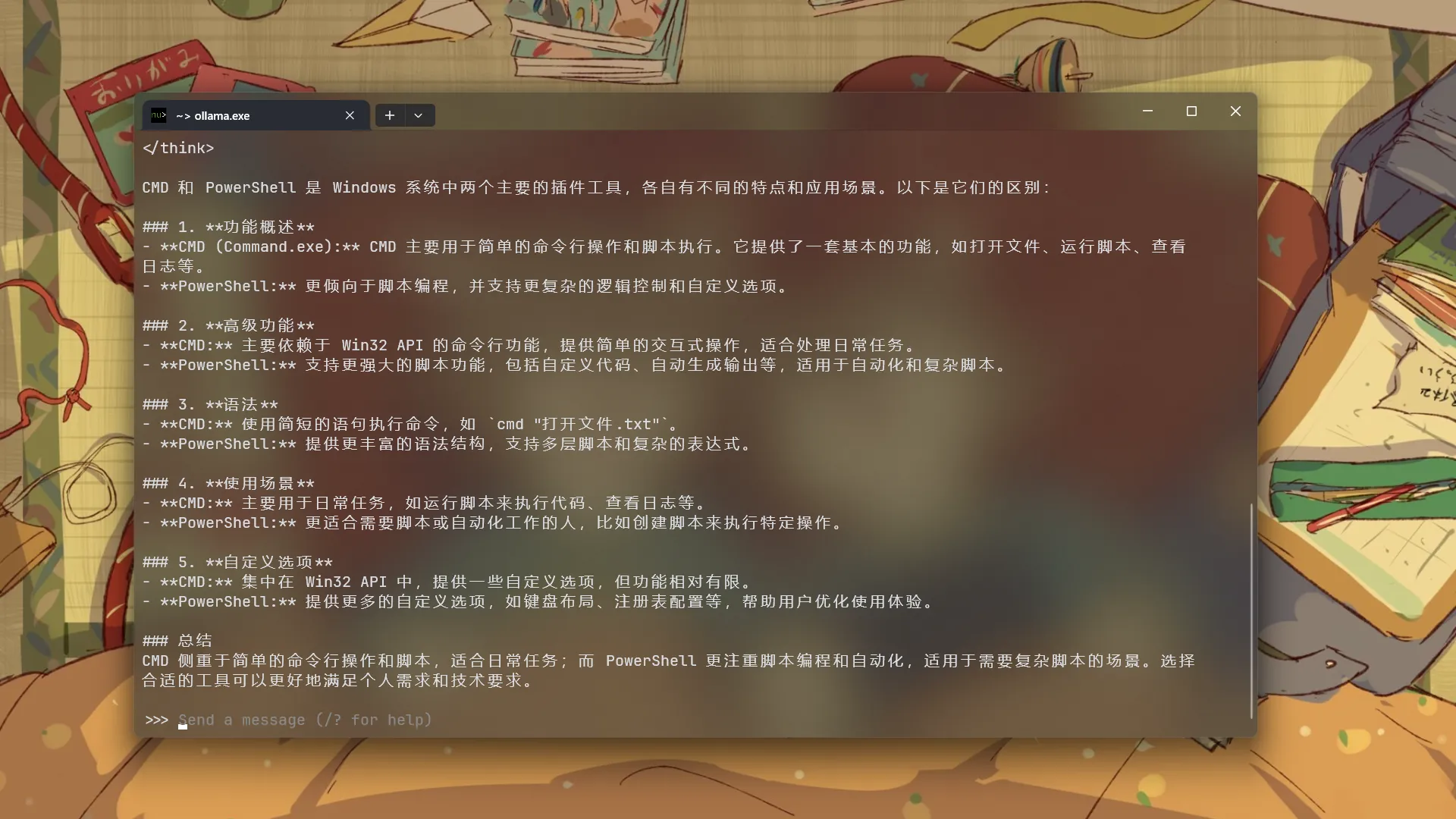

选择完成后,复制并运行右边的命令,例如这样:

ollama run deepseek-r1:1.5b等待安装,安装完成后就可以使用了。如果以后还想继续使用,只需输入同样的命令。

如果此时间过长,文中的信息可能会失去时效性,甚至不再准确。